Quando si parla di big data si fa riferimento a un patrimonio informativo di elevato volume, grande velocità e varietà, che richiede forme innovative ed efficienti di interpretazioni di dati per poter dare un valido contributo ai processi decisionali e all’automazione dei processi.

Non si tratta di un tentativo recente di quantificare la dimensione del flusso informativo, in quanto già settant’anni fa ci sono stati i primi esperimenti che miravano a individuare il tasso di crescita del volume di dati, noto a tutti come “esplosione di informazioni” (termine apparso per la prima volta nel 1941, secondo l’Oxford English Dictionary). Con il tempo è diventata sempre più impellente l’esigenza di archiviare questo patrimonio in modo razionale, seguendo una metodologia che possa portare alla loro comprensione in modo automatizzato.

La prima volta che un articolo scientifico ha parlato di big data è stato quando i ricercatori Steve Bryson, David Kenwright, Michael Cox, David Ellsworth e Robert Haimes, nel 1999, sulla rivista “Communications of the ACM”, hanno sottolineato l’importanza di fare uno “sforzo” significativo per comprendete questo enorme ammontare di dati.

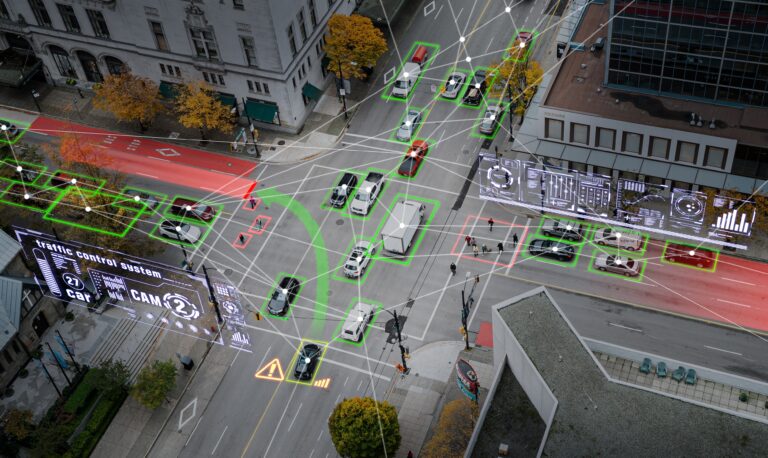

Il flusso informativo non accenna ad arrestarsi, anzi secondo gli esperti si avrà un aumento del 4300 per cento nella generazione di dati annuali, entro il 2020. Oggi si parla spesso di big data in relazione all’Internet of Things, in quanto gli oggetti “connessi” generano un prezioso ed esteso patrimonio informativo.