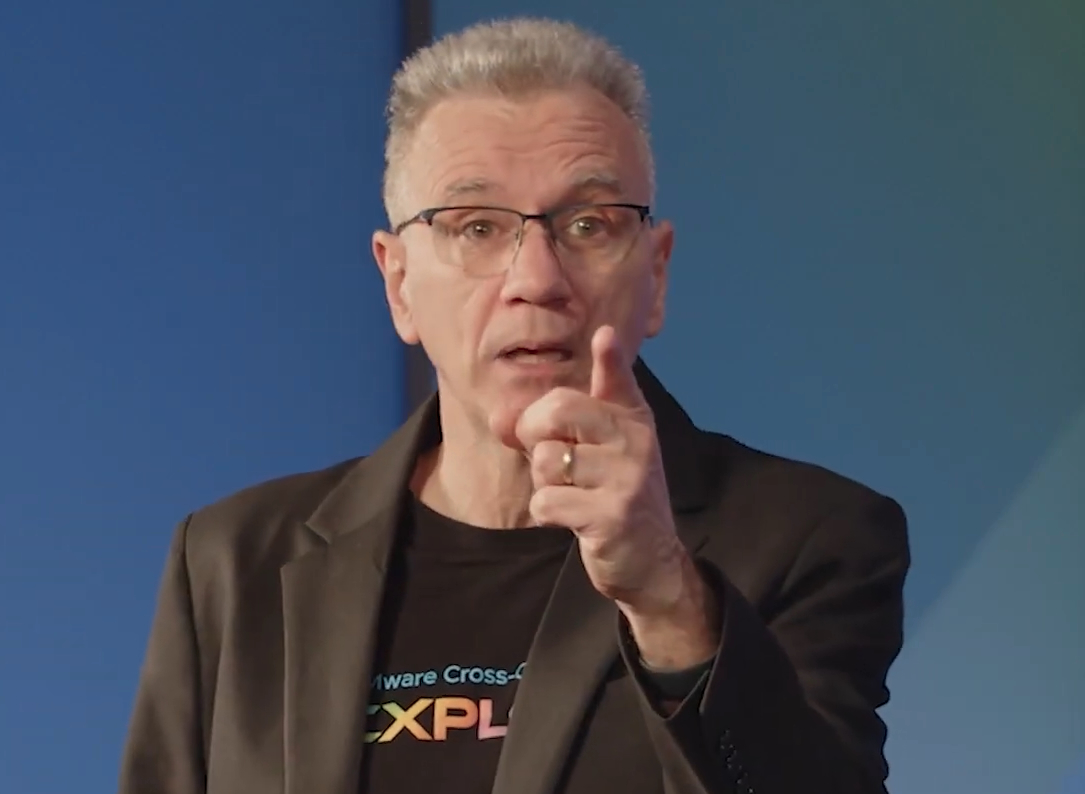

L’industria tecnologica sta attraversando una fase di maturazione profonda, in cui l’identità di una startup AI non è più definita semplicemente dall’adozione di un modello linguistico, ma dalla capacità di dominarne l’architettura operativa e l’integrazione funzionale. La percezione di un mercato dominato esclusivamente da soluzioni consumer, nate sulla scia del successo globale di ChatGPT, sta lasciando il posto a una realtà industriale in cui il segmento B2B e il supporto diretto ai fondatori rappresentano il vero motore dell’innovazione. Le riflessioni emerse durante il recente TechCrunch Disrupt 2025, documentate nel corso di un’intervista condotta dall’AI editor Russell Brandom a Marc Manara, Head of Startups di OpenAI, delineano un ecosistema che ha ormai superato la fase della sperimentazione per entrare in quella dell’efficienza e della creazione di valore su scala globale.

strategie aziendali

OpenAI, parla l’Head of Startups Marc Manara: “Puntiamo sulle startup B2B”

Marc Manara di OpenAI spiega come l’azienda lavora con le startup, partendo dalle loro necessità concrete per costruire API e piattaforme che rispondano a bisogni operativi specifici. “Permane un business consumer di successo, ma gli investimenti più pesanti sono nel B2B”

Continua a leggere questo articolo

Aziende

Argomenti

Canali

INNOVATION LEADER

-

Massimiliano Garri (Gruppo FS) racconta l’approccio all’innovazione con hub internazionali e presto investimenti diretti sulle startup

09 Mar 2026 -

Dalla sperimentazione all’adozione su larga scala: ecco come Leonardo fa innovazione e open innovation

06 Mar 2026 -

Alessandro Nervegna alla guida di Ferrero Core: quando l’innovazione diventa mestiere da CEO

05 Mar 2026 -

Francesca Porta e la sfida della Human Readiness in Autogrill: l’AI non va insegnata, va allenata

26 Feb 2026 -

L’evoluzione dell’open innovation nell’era dell’AI: parla Jelena Weil, Venture Innovation di AWS

26 Feb 2026