Per gran parte del 2023 e del 2024 il dibattito sull’Intelligenza Artificiale Generativa nelle aziende è rimasto sospeso tra entusiasmo messianico e scetticismo difensivo. Da un lato c’era chi prometteva la rivoluzione totale entro il venerdì pomeriggio; dall’altro, chi bollava il tutto come una bolla speculativa, destinata a sgonfiarsi non appena fosse passato l’effetto novità.

IL REPORT

Enterprise AI 2025 di Open AI: l’era della sperimentazione è finita, i 5 pilastri del cambiamento

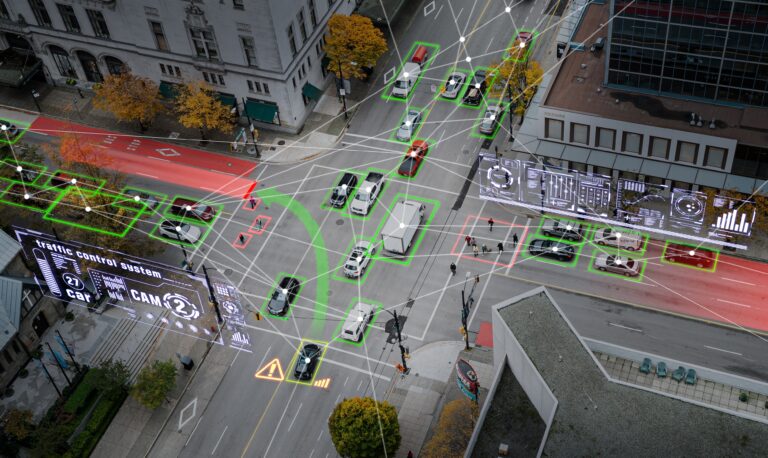

La fase “sandbox” sull’intelligenza artificiale generativa – quella dei progetti pilota isolati, delle licenze assegnate a macchia di leopardo e dell’utilizzo destrutturato — si è conclusa. I dati dicono che siamo entrati nella fase di industrializzazione. Ecco le implicazioni per il business

Imprenditore e investitore

Continua a leggere questo articolo

Canali

INNOVATION LEADER

-

Stefano Brandinali cambia ma resta nel pharma: da Chief Innovation Officer di Angelini a CIO di Chiesi

22 Gen 2026 -

Silvia Celani da Open Fiber a Head of Innovation della società di consulenza PNO Innovation

16 Gen 2026 -

Alessandro Braga (Veolia) racconta Research Gateway: l’innovazione che nasce dalla ricerca

07 Gen 2026 -

Enrico Pochettino (Iren): ecco perché nel deep tech servono pazienza e industria

29 Dic 2025 -

Come sviluppare l’innovazione in una media azienda: il caso Irinox

26 Dic 2025