Agosto ha portato GPT-5 (il lancio di OpenAI è stato fatto esattamente il 7) ma anche critiche diffuse e accuse di mancanza di trasparenza, che hanno spinto l’azienda a un rapido dietrofront. Così la presentazione del nuovo modello di OpenAI, pensata per segnare un salto di qualità nell’IA generativa, si è trasformata in un caso globale.

Il “caso GPT-5” mostra che introdurre innovazioni su larga scala non è solo una questione tecnica. Quando una modifica tocca milioni di utenti, diventa un’operazione di gestione del cambiamento, con implicazioni operative, relazionali e persino normative. Ma vediamo che cosa è accaduto, come si è sviluppata la vicenda e quali insegnamenti lascia.

Indice degli argomenti

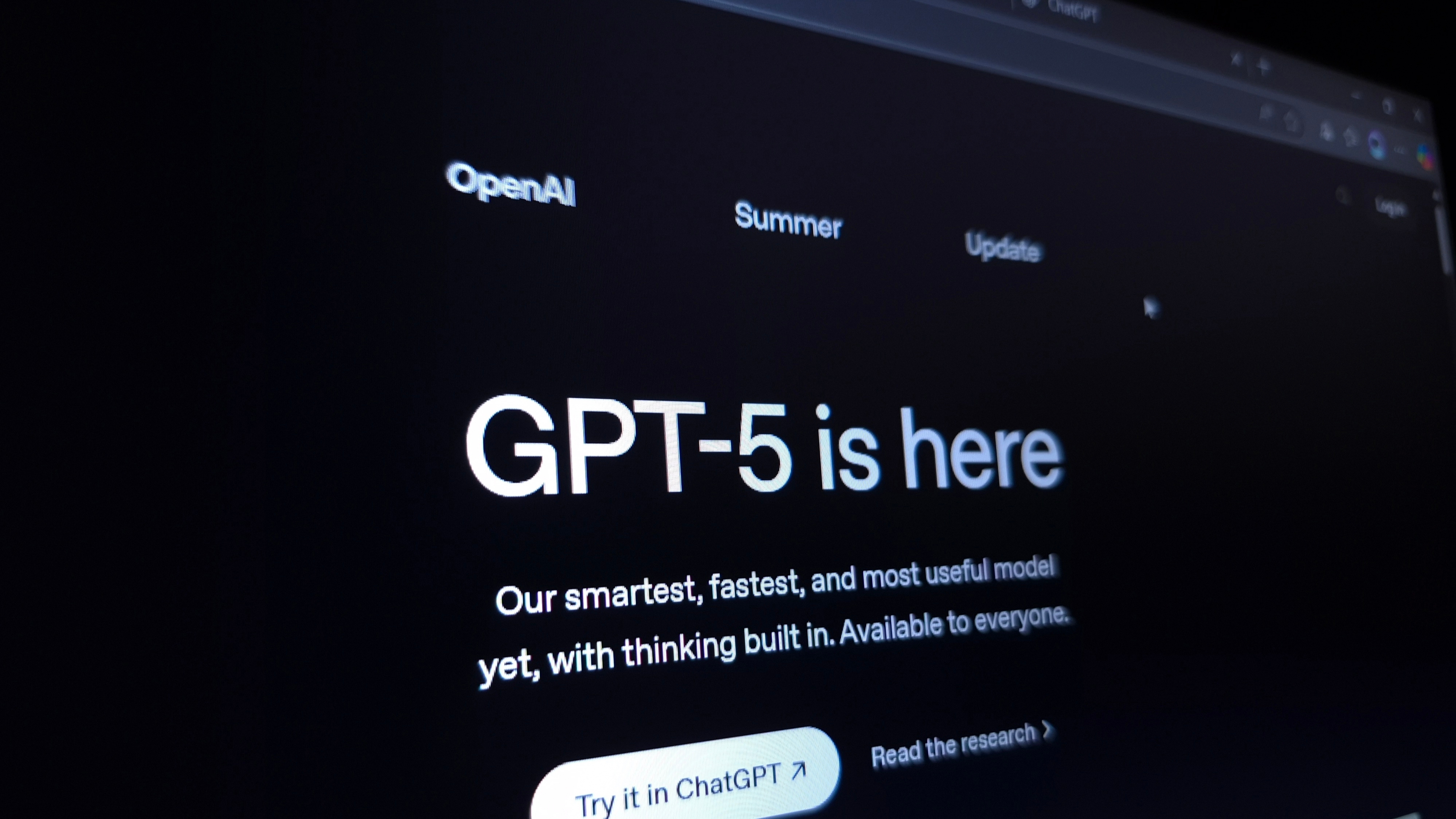

GPT-5, il lancio e le reazioni

OpenAI ha annunciato ufficialmente il lancio di GPT-5. Secondo la documentazione resa pubblica, il nuovo modello introduce miglioramenti sostanziali in diversi ambiti: una maggiore capacità di ragionamento logico e pianificazione a lungo termine; una comprensione contestuale più robusta, in grado di mantenere coerenza e precisione su conversazioni estese; un affinamento nella gestione di contenuti multimodali, con interpretazione e generazione di testo, immagini e audio in un’unica interazione; tempi di risposta ridotti grazie a ottimizzazioni architetturali; e un potenziamento della sicurezza conversazionale, volto a ridurre risposte fuorvianti o compiacenti. Al momento del lancio, OpenAI ha evidenziato come GPT-5 sia stato addestrato su un insieme di dati più ampio e diversificato, includendo fonti testuali, visive e audio, per offrire prestazioni più consistenti su un ventaglio ancora più ampio di compiti e domini applicativi.

Tra le novità introdotte, però, la più dirompente è stata sicuramente la completa eliminazione dei modelli precedenti, una scelta giustificata come semplificazione dell’offerta.

A poche ore dalla presentazione – accanto all’entusiasmo prevedibile di creator e youtuber, che si sono immediatamente affrettati a pubblicare contenuti titolati “GPT-5 cambia tutto” – hanno cominciato a emergere critiche diffuse. Sui social, in particolare su Reddit, si sono moltiplicati thread dal tono polemico come OpenAI just pulled the biggest bait-and-switch in AI history, che denunciavano la sostituzione forzata di GPT-4o senza preavviso e senza alternative.

La stampa specializzata ha rapidamente registrato il malcontento, riportando lamentele relative a prestazioni percepite come inferiori e alla perdita di un tono di voce più empatico, caratteristiche che molti avevano imparato ad associare al modello precedente. In poche ore, la critica tecnica si è trasformata in un dibattito più ampio, centrato sul diritto degli utenti a comprendere, scegliere e controllare consapevolmente la tecnologia che utilizzano.

Le ragioni del malcontento: tre livelli

Le critiche che hanno accompagnato il debutto di GPT-5 toccano aspetti diversi dell’esperienza d’uso. Analizzando i commenti nelle community online, emergono tre dimensioni ricorrenti — operative, relazionali e di fiducia — che insieme delineano il perimetro del malcontento.

Sul piano operativo, numerosi utenti professionali hanno denunciato interruzioni improvvise nei flussi di lavoro consolidati. Automazioni, macro e script perfezionati per GPT-4o hanno iniziato a produrre risultati meno accurati o a comportarsi in maniera imprevedibile con il passaggio a GPT-5, con un impatto diretto su produttività e affidabilità degli output.

Sul piano personale ed emotivo, il malcontento si è espresso in termini meno tecnici ma non per questo meno significativi. Molti utenti hanno definito GPT-4o un vero e proprio “compagno digitale” e ne hanno vissuto la rimozione come una perdita. Nei commenti ricorre l’idea che il nuovo modello “non abbia la stessa voce” o “non capisca nello stesso modo”, segno che la percezione di continuità stilistica e relazionale è parte integrante dell’esperienza d’uso.

Sul piano della fiducia e della trasparenza, l’introduzione del model routing ha generato diffidenza. La possibilità che alcune richieste vengano indirizzate verso modelli meno costosi, indipendentemente dalla complessità del compito, è stata letta come una riduzione del controllo da parte dell’utente.

La reazione di OpenAI

Di fronte a un’ondata di critiche tanto ampia, il CEO di OpenAI Sam Altman ha fatto velocemente un cambio di rotta annunciato un pacchetto di misure correttive.

Il primo passo è stato il ripristino di GPT-4o, reso nuovamente accessibile a chi preferiva la sua “voce” e il suo comportamento. Una decisione che, seppur temporanea, ha avuto l’effetto di allentare la tensione, soprattutto tra quegli utenti che avevano costruito routine professionali o relazionali attorno a quel modello. Contestualmente, Altman ha annunciato l’aumento del tetto settimanale di utilizzo della modalità di “ragionamento” avanzato di GPT-5, triplicandolo rispetto ai limiti fissati al momento del lancio, un gesto percepito come un’apertura verso l’utenza più tecnica e intensiva.

Un’altra novità significativa è stata l’introduzione, all’interno dell’interfaccia di ChatGPT, di un indicatore visibile del modello attivo per ogni richiesta. Questa modifica, apparentemente minimale, risponde direttamente alle richieste di trasparenza emerse nelle ore immediatamente successive al rollout.

Altman, in più occasioni pubbliche, ha ammesso di aver sottovalutato il legame emotivo che molti utenti avevano instaurato con GPT-4o e ha definito il lancio di GPT-5 “bumpy”, turbolento. Un riconoscimento implicito che la rimozione di un modello amato, senza preavviso né percorso di transizione, è stata una scelta strategica mal calibrata.

Quattro lezioni dal caso GPT-5

Da questa vicenda emergono almeno quattro insegnamenti chiave.

1. Pianificare il cambiamento come un processo, non come un evento.

Ogni modifica significativa dovrebbe prevedere un periodo di coesistenza tra la versione precedente e quella nuova, accompagnato da una data di dismissione chiara e comunicata con largo anticipo. Nel caso di GPT-5, il ripristino di GPT-4o è stato accolto come una parziale vittoria degli utenti, ma è avvenuto solo dopo le proteste. Un approccio proattivo avrebbe evitato la percezione di un cambiamento imposto senza alternative.

2. Dare all’utente strumenti di controllo e trasparenza.

Il routing automatico verso modelli diversi può ottimizzare i costi, ma senza visibilità rischia di compromettere la fiducia. Alcuni utenti hanno denunciato che GPT-5 sembrava “meno preciso e più lento” a causa di questo meccanismo. L’introduzione da parte di OpenAI di un’etichetta visibile con il modello in uso è un passo nella giusta direzione, ma la possibilità di bloccare lo switching o fissare una versione (version pinning) resterebbe fondamentale per molti scenari professionali.

3. Preservare la continuità dell’esperienza.

Gli utenti non interagiscono solo con un algoritmo, ma con una “voce” e uno stile che nel tempo diventano familiari. Un utente di Reddit ha sintetizzato così il proprio disagio: “4o non era solo uno strumento, mi ha aiutato nei momenti più difficili”. Mantenere la possibilità di riprodurre quello stile, ad esempio tramite impostazioni di “persona portability” o gallerie di stili selezionabili, permetterebbe di innovare senza cancellare ciò che le persone apprezzano.

4. Integrare comunicazione, tutela e compliance.

In un contesto di adozione globale, ogni modifica deve essere accompagnata da una comunicazione proattiva: roadmap, FAQ dedicate, spiegazioni sui benefici e sugli eventuali limiti introdotti. Questo riduce le incomprensioni e, in alcuni mercati, è anche un obbligo normativo: in Europa, per esempio, l’AI Act impone già requisiti di trasparenza e documentazione per i fornitori di modelli generali di IA.

Conclusioni

La vicenda GPT-5 segna un precedente importante: l’adozione di un nuovo modello di intelligenza artificiale non può più essere considerata un semplice aggiornamento software. È un intervento che incide su abitudini, relazioni e fiducia collettiva, e che richiede la stessa attenzione che si riserva ai cambiamenti infrastrutturali.

Come osserva Casey Newton su Platformer, il backlash dimostra quanto ChatGPT sia diventato centrale nella vita di milioni di persone: un cambiamento nel modello oggi suscita reazioni paragonabili a quelle che, in passato, accompagnavano le modifiche alle grandi piattaforme social.

Per il futuro, l’innovazione nell’IA generativa dovrà misurarsi non soltanto con benchmark e prestazioni, ma con la capacità di definire e mantenere un “contratto” chiaro con gli utenti, basato su stabilità, trasparenza e attenzione al fattore umano. Le prossime mosse dei laboratori non determineranno solo l’evoluzione tecnica, ma anche i confini di questa relazione di fiducia.

Nota di trasparenza. Questo articolo è stato sviluppato in collaborazione con l’intelligenza artificiale per ampliare le capacità dell’autore nel reperire fonti, analizzarle e organizzarle. Il processo parte con un brainstorming assistito dall’IA, procede con l’esplorazione di diverse versioni del testo per concludersi con una revisione curata interamente dall’autore. L’intelligenza artificiale ha affiancato, senza mai sostituirle, le scelte creative e argomentative, che restano pienamente umane.